當前,全球數字經濟正逐漸向以人工智能(néng)(AI)為核心驅動力的智能經濟新階段邁進。AI技術在各行業得到廣泛(fàn)應用,但在為經濟和社會發展注入新動能的同(tóng)時,也帶來了監管難題。為此,2021年4月,歐盟發(fā)布《人工(gōng)智能(néng)法》提案(以下簡稱《法案》),提出了(le)AI統一監(jiān)管規(guī)則,旨在(zài)從(cóng)國(guó)家法律層麵限(xiàn)製AI技術發展帶來的潛在風險和不良影(yǐng)響,使AI技術(shù)在符合歐(ōu)洲(zhōu)價值觀和基本權利的基礎上技術應用創新得到進一步加強,讓歐(ōu)洲成為可信賴的全球AI中心。作為AI領域(yù)的“GDPR”,該《法案》是全球首部AI管製法律,研究其內容和創(chuàng)新點,對製定(dìng)我(wǒ)國AI等數字技術(shù)治理方案具(jù)有重要借鑒意義(yì)。

《法案》核心內容

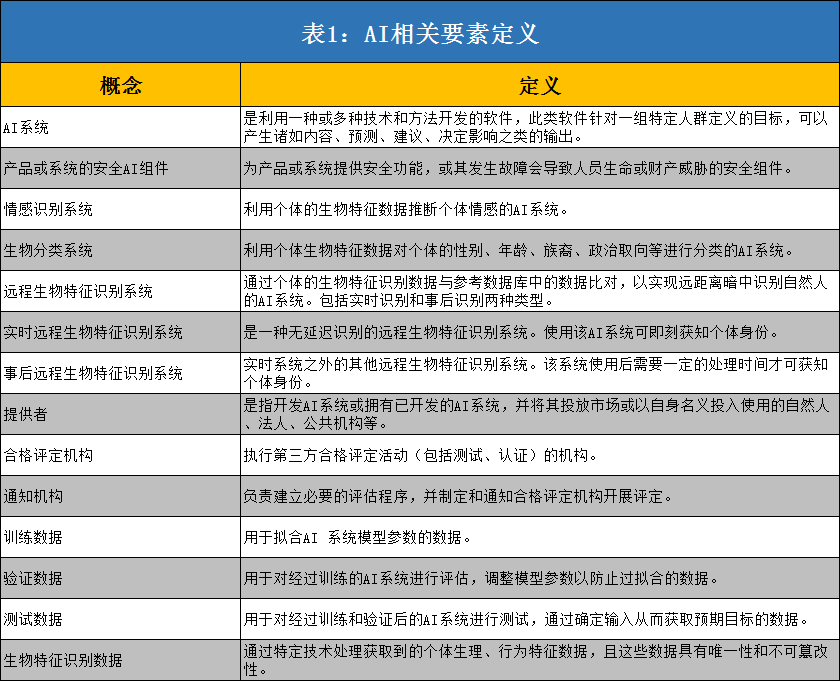

寬泛定義了AI係統,並(bìng)設置了AI規則的域(yù)外適用性(xìng)。一方(fāng)麵,《法案》定義(yì)了AI係統、AI係統供應鏈(liàn)上涉及到的相(xiàng)關環節以及不同類別的AI數據等相關要(yào)素,對監管對象(AI係統)的(de)定義表現出極強的寬泛(fàn)性,幾乎涵蓋了全部使用傳(chuán)統及新(xīn)興AI技術的係統(AI技術使用常態化的互(hù)聯網服務均為(wéi)監管對象),與GDPR中對受監管的個人數據(jù)的寬泛定義保(bǎo)持一致。另一方(fāng)麵,《法案》明確了所有在歐盟市(shì)場投放、使用AI係統及相關服務的國內外(wài)供應商、服務商和公共服務用戶提供者,隻(zhī)要其AI係統影響到歐盟及歐盟公民的,均將受到《法案》約束,從而保證(zhèng)了AI規則的域外適用性。

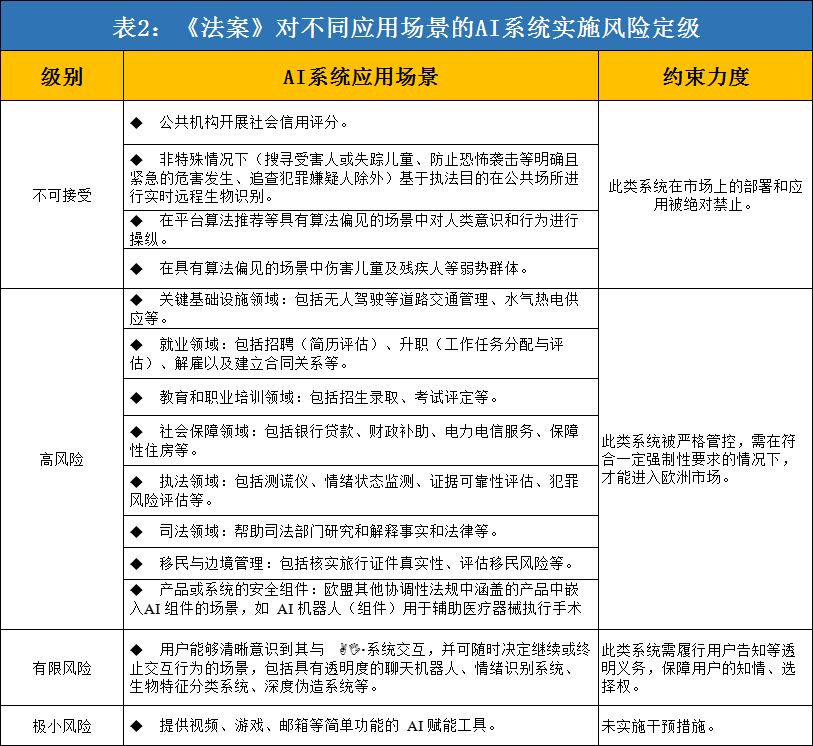

對不同應用(yòng)場景的AI係統實施風險定級,並分別提出規製路徑。《法案》基於不同應用場景的風險差異性(xìng),將AI係統分為“不可接受、高、有限、極小”四個風險等級,並針對不同級別風險(xiǎn)實施不同(tóng)程(chéng)度的規製,從而構建起以風(fēng)險為基礎的四級治理體係。一是將(jiāng)對基本人權和社會(huì)公平構成明顯威(wēi)脅的AI係統視為“不可接受”;二是將可能(néng)危及公民人身安全及生活基本權利場景中的AI係統視為“高風(fēng)險”;三是將具有特定透明度義務的AI係(xì)統視為“有限風險”;四是將提供簡單工具性功能的AI係統視為“極(jí)小風險”。

為在特定領域提供“高風險”AI係統的企(qǐ)業提出“全生命周期”式的多(duō)重合規要求,旨(zhǐ)在增強AI產品及服務的透明度。《法案》重(chóng)點對“高風險”AI係統的開發、部署(shǔ)和應用等全生命周期提出了(le)係列規範,並要求企業等AI係統供應商履行以下透明化義務:一是在AI係統開發過程(chéng)中,建立風險管(guǎn)理係統、進行數據質量檢驗、設計用戶告知(zhī)和日誌追溯功能(néng)、搭建網絡安全(quán)保障(zhàng)能力、編製用於(yú)監管審計的技術信息文件等。二是在AI係統首次運營前或係統升級迭代後,及時開展合規性評估,並在歐盟委員(yuán)會建立(lì)和管理的大數據庫中進行備案登記。三是在AI係統投入使用過程中,建立與AI風險級別相匹配適應的售後監測係統與人為監督機製,對(duì)AI應用中的風險進行監控預警,在發現可能的風險後(hòu)召回係統處理並通知相關監管機構。四是在AI係(xì)統發生故障(zhàng)或嚴重事(shì)故時,應立即采取補(bǔ)救措施(shī),並(bìng)在(zài)半個月內向相關監管部門報告。

設立專項AI監督(dū)機構,加大監管執法力度。在AI監管主體方麵,《法(fǎ)案》提出將通過建(jiàn)立歐洲人工智能委員會,推動AI新規則的實施完善,以及後(hòu)續AI標準的製定出台,並借此構建各國監管部門的聯絡渠道(dào),協調歐盟層麵的AI監管政策,以保持AI監管體係的統一性。此外,要求各成員國建立通知機(jī)構,指定(dìng)和通知第三方合格評定機構開展監管評估,並定期將監管調查信息發送至AI委(wěi)員會。在AI監管執(zhí)法方麵,《法案》提出將對創建或應用AI係統過程中的違法企業處以高達約3600萬美元的行政罰款,或全球年度總營業額(é)的2%-6%,取兩者中最高的金額進行處罰。相(xiàng)比GDPR中4%年營業額的罰款金額,《法案》的(de)AI監管處罰力度進一步加大。此外,將撤回未在規定時間內實(shí)施整改措施企業的AI係統,並限製其市場銷售。

《法案》亮點分析

與GDPR有效銜接,進一步明確(què)了AI係統的數據治(zhì)理要求。數據和算法是AI技術的核心要素,AI係統通過數據喂養進(jìn)行算法模型優化,算法模型也(yě)應用於對個人(rén)數據的(de)深(shēn)度挖掘,實現基於學習的智能化服務(wù)。為此,《法案》重點關注了AI係統的數據安全和算法歧視偏見等問題(tí),並進行了明確規製,包括:AI係統在收集用(yòng)戶數據(jù)前需履行告知義務,以保證用戶的知情權和選擇權,確保數據采集的合(hé)法性;在訓練、驗證、測試“高風險”AI係統數據集時,應完成數據質量檢驗、算法偏見評估檢查等要求;在(zài)AI監管沙盒中處理個(gè)人數據時,應保證個人數據均處(chù)於功能獨立、隔離且受保(bǎo)護的數據處理環境中,並需實施授權訪問和數(shù)據刪(shān)除機製。

搭建具備可拓展性的法律框架,彌補了(le)技(jì)術監管的滯後性缺陷。麵對飛速(sù)發展的AI等新興數字技術,法律的適用性持續時(shí)間往往較短,新製定的(de)法律規(guī)定可能很快(kuài)就無法(fǎ)適用於實際情況,難以實現對迭代快速(sù)的AI技術進行全麵監(jiān)管,AI領域的法製體(tǐ)係滯後性凸顯。為此,《法(fǎ)案》專門預(yù)留了及時調整更新法律的空間,通過設臵“動態(tài)清單”,巧妙化解了法(fǎ)律滯後性和技術飛速發展之間的矛盾。例如,對AI係統的定義,《法案》以附件形式詳細(xì)列舉了屬(shǔ)於AI範圍內的技術(shù)和方法清單,並通過更新清單機製,保持與最前沿AI技術的同步性;針對“高風險”AI係統的界定,《法案》製定了“高風險”清單,並賦予人工智能委員會結合(hé)風險多邊性判斷並提出添加新“高風(fēng)險”應用場景建議的權利,以確保法律的及時更新。

實施對人工智能係統(tǒng)的分類分級監管,構建係統性(xìng)AI治理(lǐ)體係。AI技術具有跨學科、前沿知識融合等(děng)複雜屬性,不同AI係(xì)統在相同場景中可造成不同(tóng)種類的風險,相同AI係統在不同場景中應用也可能帶來不同種類(lèi)或不同程度的風險。為此,《法案》采用分類(lèi)分級思路,在(zài)梳理重點應用(yòng)場景類別的基礎上,對不同應(yīng)用場景按照AI係統風險可能的影響程度和危害性(xìng)質實施(shī)不(bú)同等級的分類治理,替代(dài)對不(bú)同場景(jǐng)的AI風險進行分散專(zhuān)項治理(lǐ)的傳(chuán)統路徑。通過構(gòu)建清晰且係統性的治理框架,實現對AI係統複雜性風險的“降維”治理。

率先建立AI監管沙盒機(jī)製,探索監管(guǎn)人工智能(néng)風險的新模式。技術規(guī)製(zhì)的法律(lǜ)製定常見難點之一就是如何在實現有效監管的同時,兼顧技術創新發展,鼓(gǔ)勵企業負責任的創新行為。為此(cǐ),《法案》提出通過建立AI監管沙盒,為AI係統的開發、部署、驗證、測試提供了一個可控的隔(gé)離環境,使歐洲企業可在免責條件下進行(háng)AI相關的試驗和創新,且試驗全過程受(shòu)到(dào)監管部門的監督。通過在(zài)可(kě)控範圍內實行容錯糾錯機製,在杜絕AI未知問題向不可控外部環境(jìng)擴散風險的同時,也為AI創新企業創造了相對寬鬆的發(fā)展環境。

四點啟示

強化AI立法,製定具備銜接(jiē)性與靈活(huó)性的法律監管框架。基於AI風險的複雜性、多變性,以及其與數據安(ān)全的緊密關聯性,在探索AI法律規製(zhì)路徑時,可(kě)參(cān)考歐盟《法案》亮點(diǎn),增強法律內容的銜接協調與(yǔ)靈活開放特性。一方麵,確保AI法律與《網絡安全法》、《民典法》、《數據安全法》、《個人(rén)信息保護法(草案)》四項數(shù)據和個人信息保護基本法的(de)有效(xiào)銜接,明確AI語境下的數據安全及(jí)個(gè)人隱私保護原則,規製AI數據安全(quán)風(fēng)險。另一方麵,針對AI技術(shù)、“高中低”風(fēng)險應用(yòng)場景等具有變化特征的概念實施動(dòng)態定義,通過(guò)設臵清(qīng)單列表並(bìng)建(jiàn)立類數據庫功能的“增刪改(gǎi)查”調整機製,確保法(fǎ)律在技術發(fā)展(zhǎn)和場景變(biàn)更下的時(shí)效(xiào)性和(hé)靈活性,防止AI法律內容滯後帶來的監管困境。

探索分類分級監管路徑,依據不同應用場景精準施策(cè)。可考慮采用(yòng)《法案》中的分類分級治理思路,依托對不同場景類(lèi)別的梳理,以及場景風險(xiǎn)對(duì)個人生命和生活權利、社會秩序影響大小(xiǎo),將不同應用場(chǎng)景進(jìn)行分級,對歸屬於同一風險級別場景中的AI係(xì)統進(jìn)行統一管控,對不同風險(xiǎn)級別場景中的AI係統分別采取具有(yǒu)不同約(yuē)束程度的治理(lǐ)方式,從(cóng)而建立起自(zì)下而上限製逐步加深的“風險金字塔”規製模型(xíng)。嚐試以“風險金字塔”為抓手,構建係統精準(zhǔn)的(de)AI監管治理體係,解決長久以來麵臨複雜多樣的AI係統風險(xiǎn)時監管效能低下的困境。

明確企業在AI產品開(kāi)發、運營過程中的強(qiáng)製性義務,提高AI係統的透明度(dù)。要求企業在AI產品開發過(guò)程中,建立完善的AI係統風險管控流程,包(bāo)括開(kāi)展數據質量檢驗避免數據投毒等事件發生、建立日誌(zhì)追溯機製強化風險的歸(guī)因溯源、建設網絡安全保障能力防止數據泄露等;在(zài)AI產品投入市場使用前或係統改造後,定期通過(guò)第三方評估機構開展評(píng)估(gū)認證,向監管部門備案AI算法的設計運行機製、可能的偏見和漏(lòu)洞、AI數據安全保護(hù)和風(fēng)險管控措施(shī);在AI產品投入使(shǐ)用後,及時開展(zhǎn)監控預警,建立應急響應機製,及時(shí)處理可能的AI風險事故並同步監管部門。

多措並舉構建體係化的AI監管機(jī)製,製定包容審(shěn)慎的技術監管(guǎn)措(cuò)施。一是建立(lì)AI監管專(zhuān)項負責機構,及時(shí)跟蹤和製約AI風險(xiǎn)。AI監管機構負責跟蹤AI技(jì)術發(fā)展和應用場景(jǐng)變化,及時提出AI新風險應對、監(jiān)管範圍更新等相關建議;對各類不負責任的AI提供者實施約(yuē)談處(chù)罰,進(jìn)行有效(xiào)製約和威懾。二是完善標準體係,建立第三方機構開展AI風險檢測認證。加快製(zhì)定AI相關技(jì)術和應用的安全標準,明確各領域AI係統的審計、日誌、告知等透明(míng)性(xìng)要求與衡量指標;培(péi)育權威的第三方(fāng)AI風險評估機構,開展AI算法、透明度、數(shù)據安全風險等相關評估。三是探索設立AI沙盒監管(guǎn),探尋(xún)風險製約和創新保護之間的(de)最佳結(jié)合點。建(jiàn)議由AI監管(guǎn)的專項負責機構確定沙盒監管基本原則和條件,將具備(bèi)創新性(xìng)但風險未知的(de)AI產品或商業模(mó)式在進入市場前,預先在沙盒環境進(jìn)行迭代驗證,使用戶在(zài)受保護的環境使用AI產品或服務。

登錄

登錄